Inleiding

2 Heuristieken voor het construeren van vragen over een enkel begrip.

2.1 Relatie tussen leerstof en vraagvorm.

2.2 Gebruik van de rijkdom aan voorbeelden bij een 'begrip'.

2.3 Heuristieken voor vragen over een enkel begrip.

3 Heuristieken voor het construeren van vragen over discrimineren of combineren van begrippen.

3.1 Onderscheiden, discrimineren, classificeren, diagnosticeren.

3.2 Combineren van begrippen, inzichten etcetera bij probleemoplossen.

4 controle op de kwaliteit van de toetsvragen.

4.1 controle vooraf op de kwaliteit van de gemaakte vragen.

4.2 controle achteraf op de kwaliteit van de gemaakte vragen.

5 Het componeren van de toets.

5.1 Dekking van de stof - dekking van de doelen.

5.2 De 'moeilijkheid' van in de toets op te nemen vragen.

5.3 'Toevallig trekken' van vragen voor de toets.

6 Validiteit, betrouwbaarheid, recht, en vakbekwaamheid.

6.1 Validiteit: functioneert de toets zoals bedoeld?

6.2 De rol van het toeval; betrouwbaarheid, KR 20, objectiviteit.

6.3 Meerkeuzevragen en het begrip 'objectiviteit'.

6.4 Algemene beginselen van behoorlijk bestuur.

6.5 Richtlijnen voor vakbekwaam toetsen.

7 Essay toetsen, het opstel, werkstukken, mondeling.

7.1 Als je kùnt objectiveren, doe dat dan ook.

7.2 Doorzichtigheid ook hier een belangrijke zaak.

7.3 Modelantwoorden en waarderingsvoorschriften.

7.4 Verschillen tussen beoordelaars: wat er mee te doen?

7.5 Mondeling: eigenlijk geen speciaal geval.

8 Interpretatie van toetsresultaten.

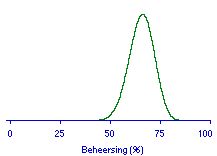

8.1 beheersing van de leerstof.

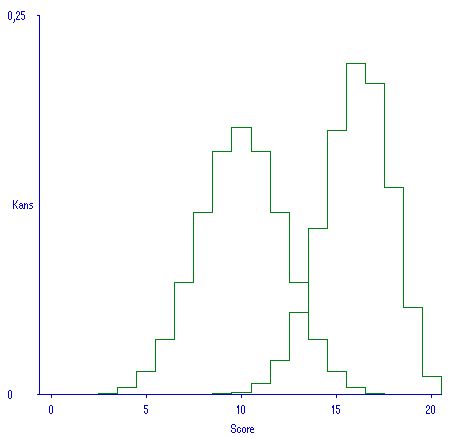

8.2 Wat valt er over de toetsscore te zeggen als de ware beheersing gegeven is?

8.3 Wat kan de student over zijn eigen ware beheersing zeggen voorafgaand aan de toets?

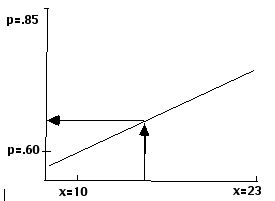

8.4 Hoe kan de student zijn toetsscore voorspellen?

8.5 Wat kan de docent zeggen over de ware beheersing van de student, gezien zijn toetsscore?

8.6 Gemiddelde, standaarddeviatie, en nog enkele begrippen.

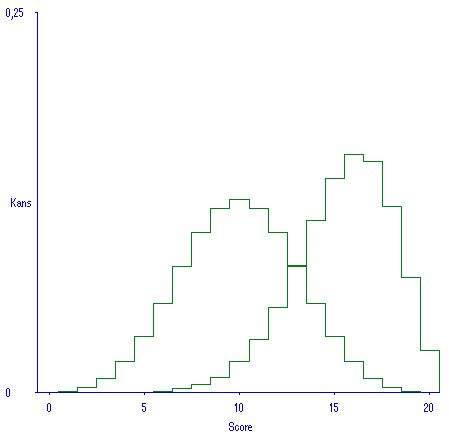

8.7 Wegstrijken van toevalligheden in de scoreverdeling.

8.8 Wat kan de docent zeggen over de ware beheersing van de groep studenten, gezien de toetsscores?

8.9 Wat kan de docent zeggen over de ware beheersing van een enkele student, nu ook een groepsresultaat bekend is?

8.10 Denk aan de veronderstellingen bij het gegeven model!

8.11 Antwoorden bij de opgaven.

Bijlage A Bij toetsgebruik in het onderwijs is klassieke betrouwbaarheid minder van belang.

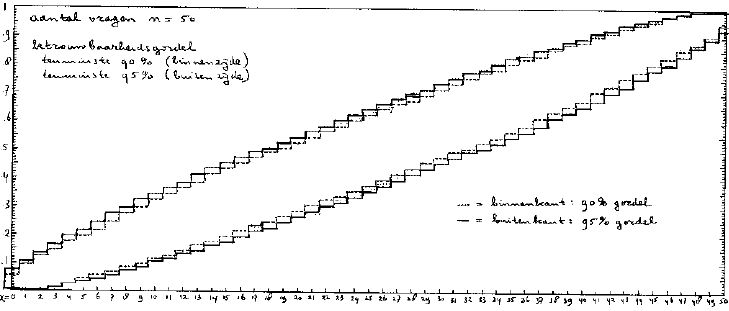

Bijlage B Betrouwbaarheidsgordels.

Gerefereerde literatuur.

Toegevoegde literatuurlijst op onderwerp.

Index.

De bewerking van de oorspronkelijke tekst naar deze web-versie is beperkt gebleven tot het strakker spellen, verbeteren van fouten en al te grote onhandigheden in taal en stijl, reconstrueren van figuren met nu beschikbare computerprogrammatuur, en hier en daar iets andere notatie van symbolen in verband met de beperkte karakterset van HTML. Het irritante gebruik van de 'je'-vorm en van de lijdende vorm heb ik ongemoeid gelaten.

In deze voorlopige versie is een eenvoudige systematiek gevolgd voor het genereren van heuristische regels voor het ontwerpen van toetsvragen, waardoor de tekst abstracter en taaier is geworden dan de bedoeling was. Dat effect is nog versterkt door het op veel plaatsen nog ontbreken van overtuigende voorbeelden van hoe het wel en hoe het niet goed gaat. Ook 'Toetsvragen schrijven' uit 1983 lijdt daar nog onder. Het is de prijs die ik betaalde voor het waagstuk het ontwerpen van toetsvragen op een nieuw fundament te plaatsen.

Het toetsen van de kennis en het inzicht dat de student in onderwijs en zelfstudie heeft opgedaan, lijkt een in plaats en tijd strikt begrensd gebeuren. De docent kan het construeren, afnemen en nakijken van toetsen ervaren als nogal losstaand van zijn andere onderwijsactiviteiten. Ondanks deze schijn van het tegendeel valt het niet lang vol te houden het toetsgebeuren te beschrijven als iets dat buiten het onderwijs zelf staat, er een beetje bijhangt, een bittere noodzakelijkheid, een wezensvreemd element. Studenten zullen trouwens ook niet verrast zijn wanneer ze een toets voorgeschoteld krijgen: daar zijn ze juist voor gekomen, daar hebben ze zich speciaal op voorbereid. Een evidentie waar toetsspecialisten weleens wat minder rekening mee houden dan wenselijk is.

Wàt je toetst, en hòe je toetst, en welke rol toetsresultaten spelen bij beslissingen die over studenten genomen worden, zijn zaken die van invloed zijn op de wijze waarop de student zich op de toetsing voorbereidt. Dat geldt voor de strengheid van de beoordeling: verhogen of verlagen van de zak-slaaggrens zal van invloed zijn op de studie-inspanning die de student bereid is zich te getroosten. Daarbij zal overigens niet vanzelfsprekend een hogere zak-slaaggrens tot een verhoogde studie-inspanning hoeven te leiden, misschien laten studenten het dan juist wat meer op een eventuele herkansing aankomen (zie de cursus Studiestrategieën html of Cesuurbepaling html). Dat geldt ook voor de openheid of juist de geheimzinnigheid rond toetsing en beoordeling. De student zal gebruik maken van alle informatie die hij kan krijgen: over de onderwerpen waarop wel of juist niet getoetst wordt, het soort vragen dat gesteld zal worden, stokpaardjes van de docent, maar bijvoorbeeld ook hoe goed zijn medestudenten zich op de toets voorbereiden. Wanneer het belangrijk genoeg is zal er zelfs handel in toetsvragen ontstaan, en zullen er georganiseerde pogingen worden' ondernomen om geheimhouding van toetsvragen te doorbreken.

Kortom: wanneer de echt belangrijke beslissingen voor de student vallen op grond van zijn behaalde toetsresultaten, dan mag je verwachten dat de student zich bij uitstek, en soms uitsluitend, in zijn studie zal richten op die kennis, inzichten en vaardigheden die metterdaad getoetst worden. Je mag er als docent nog zulke fraaie doelstellingen en goede bedoelingen op na houden, uiteindelijk is hetgeen hij daarvan in de toetsing ook mee kan nemen in hoge mate bepalend voor wat hij met zijn onderwijs bereikt. Althans wanneer het gaat om zogenaamde cognitieve vaardigheden. Met een cyclus van motiverende colleges kun je veel bereiken zelfs zonder toetsing. En hetzelfde geldt voor al die andere onderwijsactiviteiten die niet vragen om (afsluitende) toetsing.

Nu is het niet mijn bedoeling hier een cynische visie op het onderwijs te presenteren. Integendeel, ik wil er op wijzen dat wij ten onrechte geneigd zijn om het soort samenhang tussen toetsing en onderwijs dat ik zojuist schetste als ongewenst te beschouwen. Toetsing is geen Post Scriptum bij het onderwijs, maar maakt er juist integraal deel van uit. De bijzondere plaats van de toetsing daarbij is dat zij richtingbepalend is voor dat onderwijs, voor de studieactiviteiten van de student, voor de resultaten die geboekt worden, de doelstellingen die gehaald zullen worden. Toetsing, hoewel vaak geplaatst aan het eind van het onderwijs, functioneert in feite als sturingsmechanisme voor veel dat in dat voorafgaande onderwijs gebeurt. Dat neemt niet weg dat toetsing nog andere functies kan vervullen, zoals directe terugkoppeling naar de student over zijn vorderingen, zoals in geprogrammeerde instructie, toetsing als instrument voor het evalueren van je onderwijs, e.d.

Uit deze visie volgt op natuurlijke wijze dat aan de wijze van vraagstellen, het soort vragen dat je in je toets opneemt, het afbeelden van je al dan niet expliciet geformuleerde onderwijsdoelen in toetsvragen, veel aandacht te besteden is. Wat je wilt onderwijzen aan kennis en inzichten zul je ook moeten weten te toetsen, anders is het gevaar te groot dat je met je onderwijs blijft steken in de goede bedoelingen. Deze cursus probeert door het geven van een aantal heuristische regels voor het construeren van toetsvragen in te spelen op de noodzaak onderwijs en toetsing op één lijn te brengen.

Dat deze cursus regels aanbiedt voor het genereren van toetsvragen is iets dat hem onderscheidt van andere, ook van amerikaanse, cursussen. Dergelijke constructieregels zijn nog nauwelijks eerder ontwikkeld, hoewel hier en daar wel aanzetten in de literatuur te vinden zijn. Er zijn meer onderwerpen die in deze cursus op een ongebruikelijke wijze behandeld worden. Bijvoorbeeld wordt de keuze tussen meerkeuzevragen en andere, meer open vraagvormen, niet gemaakt op basis van voordelen en nadelen die dergelijke vraagvormen in het algemeen zouden hebben (hoewel gebruik van meerkeuzevragen zeker niet aangemoedigd wordt). Die keus wordt gemaakt op basis van een analyse van de aard van het inzicht waarnaar je wilt vragen.

Er wordt in deze cursus sterk de nadruk gelegd op procedures die inhoudelijke kwaliteiten van de toets en haar afzonderlijke vragen bevorderen, of meer technisch uitgedrukt: op validiteit van de toetsing, op het functioneren van de toets in overeenstemming met wat je bedoelt te bereiken met die toetsing. Daarbij wordt de meer traditionele problematiek van de betrouwbaarheid de coulissen van het onderwijstoneel ingeschoven, zij het dan ook niet zonder plaatsvervangende technieken aan te bieden die de docent bij het interpreteren van zijn toetsresultaten kan hanteren.

Door een en ander heeft deze cursus een wat alternatief karakter gekregen. Er is geen aansluiting gezocht bij bestaande en de lezer mogelijk ook al bekende teksten, hoewel ik mij er zeker niet tegen heb willen afzetten. Ik ben mij ervan bewust dat ik de lezer daarmee voor een keuze stel waar hij of zij het wel eens erg moeilijk mee zou kunnen hebben. Niets staat je echter in de weg om, mochten mijn argumenten niet de overtuiging brengen dat het Andere ook het betere is, nog eens even de kat uit de boom te kijken, kennis te nemen van het hier te presenteren materiaal, en zelf uit te maken welke toetswereld voorlopig nog het prettigst toeven lijkt.

Doelstelling van deze cursus is het aanreiken van procedures, technieken, inzichten, en informatie die de docent kan aanwenden tot het verzorgen van zijn toets en de daarmee samenhangende procedures op een wijze die verantwoord genoemd kan worden vanuit toetstechnisch en onderwijskundig gezichtspunt. Dat klinkt wat dor, maar de gegeven procedures zullen er voor de studenten toe kunnen leiden dat de toetsing een beter verteerbare zaak wordt, minder getypeerd als zwaard-van-Damocles-situatie dan wel als ploeg waar zè de hand aan te slaan is.

Iedereen kan de hier gegeven technieken hanteren wanneer zijn of haar onderwijs situatie daarom vraagt. Het zal niet direct altjd even makkelijk hoeven gaan, maar de smaak van de hier opgediende pudding bewijst zich in de eenvoudige handeling waarvoor een beweging naar de mond altijd nog wel voorwaarde is. Over het aan te bieden materiaal zul je dan ook geen vragen en opgaven aantreffen (met één uitzondering) omdat de gewenste oefening bestaat uit het direct toepassing op de eigen leerstof, de eigen toets (en de eigen collega's). Alleen het hoofdstuk over interpretatie van de toetsresultaten leent zich voor vragen en opgaven (voor wie daar plezier aan kan beleven), maar deze mogen ook best als illustratie van de toepassing van de gegeven 'theorie' beschouwd en bestudeerd worden.

Bij eerste lezing zul je er hopelijk een paar krenten voor directe komsumptie uit kunnen peuren, om deze cursus later pas weer tevoorschijn te halen wanneer er concrete problemen over de (nog af te nemen) toets of daarbij te volgen procedures op te lossen zijn.

Behandeld wordt zoveel mogelijk al datgene wat van belang is voor de docent die zelf toetsen moet construeren, die zelf de resultaten moet interpreteren. Er wordt niet ingegaan op de mogelijk wat speciale problematiek die samenhangt met het gebruik van 'gestandaardiseerde' tests, althans van toetsen die voor meerdere gebruikers gemaakt zijn. Dat wil beslist niet zeggen dat de kwalitatieve eisen waaraan de toets van een individuele docent moet voldoen niet op dezelfde wijze van belang zijn voor toetsen zoals die bijvoorbeeld door het Cito geconstrueerd worden. Bij grootschalig gebruik van een toets worden kleine verbeteringen in zo'n toets belangrijk genoeg om ze ook aan te brengen. Gebruik je een niet zelfgemaakte toets dan doet zich ook de vraag voor hoe je de kwaliteiten van die toets kunt (en moet) beoordelen; zie daarvoor in ieder geval Richtlijnen 1978.

De toets wordt niet in de eerste plaats beschouwd als meetinstrument, er zal dan ook maar weinig aandacht aan meetkwaliteiten van de toets besteed worden. In plaats daarvan ligt het accent op de overeenstemming tussen wat je toetst (wat je vraagt) en wat je in je onderwijs wilt overbrengen. De toets moet behoorlijk kunnen functioneren in de afspraken die de onderwijsinstelling met de student maakt, zoals de afspraak welke rol de toetsresultaten voor examenbeslissingen zullen spelen. Een en ander laat zich goed illustreren aan de problematiek van laten zakken of slagen: waar moet de zak-slaaggrens, de cesuur, gelegd worden? De aanwijzing van de zak-slaaggrens kan niet gebeuren op louter toetstechnische gronden, op grond van de 'meetkwaliteiten' van de toets. De plaats van de zak-slaaggrens zal wel iets te maken moeten hebben met de doelstellingen zoals die voor groepen studenten als de onderhavige haalbaar blijken. Maar vooral is de zak-slaaggrens te zien als essentiëel onderdeel van de (eenzijdige) afspraak met de student: scoor je tenminste gelijk aan deze cesuur dan wordt je prestatie voldoende beoordeeld. Uiteraard wordt tevoren bekend gemaakt waar de grens zal liggen, zodat de student tevoren weet welke prestatie een voldoende oplevert en hij zijn voorbereiding daarnaar kan inrichten. De problematiek van het kiezen van de zak-slaaggrens is dan nog wel iets gedetailleerder in te vullen dan hier gesuggereerd lijkt te worden. Daar is zelfs zoveel over te zeggen dat een afzonderlijk hoofdstuk in deze cursus daar niet toereikend voor zal zijn: er is een afzonderlijke cursus Cesuurbepaling beschikbaar (Wilbrink 1980 html).

Een ander belangrijk onderwerp dat hier maar zijdelings aangeraakt wordt, betreft de wijze waarop de student zich voor kan bereiden op het binnen halen van de door hem verlangde resultaten: daar wordt in de cursus Studiestrategieën (Wilbrink 1978 html) uitgebreid op ingegaan.

Aan de leerstofkant wordt volstaan met de veronderstelling dat een opsomming van te behandelen onderwerpen die stof ook goed kan beschrijven. Ligt er in tegenstelling tot die aanname een zwaar accent op onderlinge relaties tussen die onderwerpen, op de structuur van teksten, dan is voor het in kaart brengen van die leerstof de cursus met diezelfde titel (Breuker, 1979) aangewezen.

Is het maken van toetsvragen een kunst? Je zou het wel zeggen wanneer je in het ene handboek na het andere ontboezemingen tegenkomt in de trant van 'je moet het maar in de vingers hebben', je moet over de nodige 'inspiratie' kunnen beschikken, het bedenken van goede vragen is een kunst, inderdaad, en 'je moet altijd open staan voor de creatieve inval' onder het afwassen, op weg naar je werk, or what not. Aan de andere kant zijn daar de vele ervaringen van het snel opgedroogd zijn, na enkele keren een toets in elkaar gezet te hebben, van de 'ideënstroom' die aan de vraagconstructie ten grond lag, zodat de steeds grotere moeite bij het bedenken van telkens weer nieuwe vragen over dezelfde stof leidt tot vragen van steeds trivialer karakter, minder over hoofdzaken en meer over bijzaken van de stof. Wie dan verdere inspiratie zoekt bij literatuur over het maken van studietoetsen komt teleurgesteld uit, hem worden stenen voor brood geboden: opsommingen van fouten die je bij het formuleren van vragen zou moeten vermijden, maar geen regels hoe je om te beginnen goede vragen over de stof zou kunnen formuleren.

Welnu, deze leemte wil ik graag opvullen in dit en het volgende hoofdstuk, waarin ik zal proberen een fors aantal vuistregels te geven die het mogelijk maken om niet alleen binnen korte tijd een groot aantal vragen over een stukje leerstof te construeren, maar bovendien dat vragen laten zijn die een redelijk hoge mate van laten we maar zeggen onderwijskundige 'zin' hebben. Deze cursus is de eerste presentatie van wat ik in het vervolg 'heuristieken voor het construeren van vragen', of vraagheuristieken zal noemen, en ik vlij mezelf niet met de gedachte dat ik in deze wonderschone opzet op stel en sprong ook volledig zou kunnen slagen. Ook moet ik in zoverre bescheiden zijn, dat ik steun op werk dat anderen voor mij verricht hebben, waarbij ik hier speciaal wil noemen het werk van Klausmeier en zijn medewerkers die in hun research naar de ontwikkeling van het begripsmatige denken bij kinderen toetsingsinstrumenten ontwikkelden langs ongeveer dezelfde lijn als hier door mij gepresenteerd.

Ik ga er in het volgende van uit dat de te toetsen leerstof zich laat opdelen in daarin afzonderlijk, zij het ook niet zonder relatie tot elkaar, behandelde onderwerpen. In plaats van over 'onderwerpen' zal ik verder over 'begrippen' spreken, en ik gebruik dat als een soort verzamelterm voor 'wetten', 'modellen', 'technieken', 'klassen', etc.:

------------------------------------------------------------------------

'begrippen' zijn: regels ziektebeelden

(in ruime zin) wetten klassen

modellen taxa

theorieën procedures

paradigma's technieken

begrippen (in enge zin)

etcetera.

------------------------------------------------------------------------

De reden om begrippen als organiserend principe te kiezen is dat de menselijke wijze van omgaan met de wereld om hem heen bij uitstek een begripsmatige is. Onze greep op de wereld, niet alleen de materiële maar bijvoorbeeld ook de sociale, wordt vergroot door een betere begripsmatige kijk er op, die ons bevrijdt van het verloren raken in een baaierd van onnozele details. Dat geldt al voor de kleinste peuters, die er een genoegen in scheppen alles wat vier poten, twee oren en een staart heeft, geen poes is, en 'woef' zegt 'hond' te noemen. Dat is ook zo voor de wetenschapper die bepaalde verschijnselen probeert te 'determineren' omdat ze dan voor hem een stuk begrijpelijker zijn, hij er andere relevante kennis ook op van toepassing weet.

Dingen of gebeurtenissen die onder een en hetzelfde begrip vallen, voorbeelden van datzelfde begrip zijn, hebben een aantal typische eigenschappen met elkaar gemeen. Lukt het om een gebeurtenis correct te benoemen of te labelen, dan weet je daarmee ook welke eigenschappen de gebeurtenis nog meer heeft dan degene die je direct al had waargenomen, tenminste voorzover het eigenschappen zijn die kenmerkend zijn voor gebeurtenissen die tot dezelfde klasse behoren, onder hetzelfde begrip vallen. Vanuit de wetenschap dat iets valt onder klasse of begrip zus-en-zo kun je bepaalde voorspellingen over eigenschappen of gedrag van dat 'iets' doen vanuit je kennis over eigenschappen van alle onder dat bepaalde begrip thuis horende zaken. Ik zal hier verder niet over uitweiden, en verwijs de belangstellende lezer verder naar bijvoorbeeld Wickelgren's 'Cognitive Psychology' en Klausmeier en Allen's 'Cognitive development of children and youth.'

De intellectuele vaardigheden bij dit begripsmatig met de wereld omgaan zijn dan ook het correct thuis kunnen brengen van dingen of gebeurtenissen; het kunnen gebruiken van (kenmerkende) eigenschappen van het begrip waar het om gaat, bijvoorbeeld om er voorspellingen op te baseren; het zelf kunnen maken of aanwijzen van dingen die onder een genoemd begrip vallen, etcetera. De open peuterschool Sesamstraat, loopt over van de heel alledaagse voorbeelden van wat ik hier bedoel. Ook bij de leerstof die je je studenten aanbiedt moet het dan gaan om begripsmatige beheersing van die stof, een beheersing die de student in staat stelt effectiever met de wereld om te gaan, geen beheersing die maar tot beperkt doel heeft uit boeken opgedane kennis in als het kan letterlijk bijna dezelfde vorm op ander papier te kunnen reproduceren. Toetsvragen moeten deze begripsmatige beheersing aanboren, geen beroep doen op uit het hoofd geleerde weetjes die o zo snel weer vervaagd zullen zijn. Meestal zal het een kleine moeite zijn een lijst te maken van alle begrippen die in de aangeboden leerstof aan de orde komen, of waarover de toets zal gaan. Ik geef een voorbeeld uit Veldkamp's Inleiding tot de analyse (1957), de begrippen die in het eerste hoofdstuk, over de reële getallen, behandeld worden:

verzameling faculteit

afbeelding volledige induktie

natuurlijke -,

gehele , en en drie met name genoemde stellingen:

rationele getallen

afbeelding op de de ongelijkheid van Bernouilly

getallenrechte het binomium van Newton

interval en omgeving de driehoeksongelijkheid

som en product

nest van segmenten.

Het gegeven lijstje is ongeveer gelijk aan de inhoudsopgave.

Dat ik een wiskunde tekst als voorbeeld heb genomen is misschien een beetje oneerlijk. Wiskunde is een door en door gestructureerd vak, terwijl in de leerboeken weinig motiverende tekst gegeven pleegt te worden. Neem je daartegenover Samuelson's Economics, dan valt op dat erg veel ruimte door motiverende tekst in beslag wordt genomen, op veel plaatsen zelfs ontaardend in pleidooien voor 'The american way of life', terwijl in de lay-out van de tekst heel slecht naar voren komt over welk begrip iedere passage nu eigenlijk handelt. Van zo'n handboek een begrippenlijst maken is een hele klus juist door de ongestructureerdheid van de tekst. Zo'n tekst als van Samuelson kan didactisch best goed zijn, de student enthousiast maken voor het vak, maar het is geen tekst die toegeschreven is op het leren omgaan met nieuwe begrippen op een wijze die zinvol toetsbaar is.

Ik ga ervan uit dat de vakdocent, ook wanneer de behandelde literatuur wollig en mistig is, zonder veel moeite een opsomming van daarin behandelde begrippen kan maken.

Nu is het uitgesloten om alles wat over een bepaald begrip weetbaar, bruikbaar of toepasbaar is ook in het onderwijs te behandelen, in de gegeven tekst te bespreken, of te toetsen. Keuzen, selecties, zullen altijd gemaakt moeten worden. Abstract bekeken ziet een lijstje 'weetbaarheden' over een bepaald begrip er ongeveer als volgt uit:

naam definitie(s) beschrijving eigenschappen voorbeelden en niet-voorbeelden relaties met andere begrippen deelbegrippen waaruit het opgebouwd is toepassingen.

Ik ga het rijtje even kort langs, en kom er bij de te behandelen vraagheuristieken uitgebreider op terug.

Het is handig wanneer het onderwerp dat je behandelt een naam heeft. Absoluut nodig is het niet, het is best mogelijk om vaardigheden te onderwijzen (of te leren) zonder daar ooit een naam aan gegeven te hebben. Kinderen kunnen grammaticaal correcte zinnen spreken zonder de grammaticale regels te kunnen noemen.

Definities zijn ook niet voor alle leerstof even onmisbaar. In de wiskunde moet je er goed mee kunnen werken. bij andere vakken kan een nadruk op definities juist een begripsmatige beheersing in de weg staan. Zo neemt Wickelgren in zijn al genoemde boek geen lijst van termen met definities op, om niet het naieve en onjuiste idee te bekrachtigen dat je al heel wat over een begrip zou weten wanneer je een definitie van een of twee zinnen kent. Een definitie kan natuurlijk een identificatiefunctie hebben: je kunt hem gebruiken om te bepalen of iets wel of niet onder het betreffende begrip valt. Je hebt aan de andere kant ook begrippen waar geen definitie voor te geven valt, zoals 'zwaartekracht' en 'intelligentie', hoewel sommige auteurs in zo'n geval dan maar pragmatische definities geven zoals 'intelligentie is datgene wat een intelligentietest meet', waar je ook weinig wijzer van wordt. Moeilijk te definiëren begrippen, je weet wel: die begrippen waar iedere auteur zijn eigen definitie voor heeft, kun je misschien beter ook maar ongedefinieerd laten.

Bij beschrijvingen komt het op de eigen bewoordingen van de docent aan, bewoordingen die als het even kan didactisch handig gekozen moeten zijn. Enige plooibaarheid ten toon gespreid bij het beschrijven in eigen woorden kan wijzen op een redelijke althans verbale beheersing van het begrip door de student.

Eigenschappen van een begrip hoeven niet per se ook definiërende eigenschappen te zijn.

Een voorbeeld van voorbeelden: voorbeelden van ecosystemen zijn de vijver, de wei, het terrarium, een ruimteschip. Begrippen waar geen voorbeelden van te geven zijn zouden wel eens zinledig kunnen zijn. Voorbeelden kunnen ook een definiërende functie bekleden: samen met gegeven niet-voorbeelden bakenen zij af wat (nog) wel en wat niet (meer) onder het bedoelde begrip valt.

Relaties met andere begrippen kunnen een wetmatig karakter hebben, en daarmee op zich ook weer een 'begrip' vormen.

Toepassingen zijn eigenlijk een bepaald soort voorbeelden. Of anders gezegd: er zijn begrippen waar het er niet zozeer om gaat om er voorbeelden van te kunnen geven of herkennen, maar er toepassingen van te kunnen geven of herkennen.

Dit alles is wel erg kortaf gezegd, maar ik wilde de lezer niet onnodig langer afhouden van het eigenlijke onderwerp van dit hoofdstuk, vraagheuristieken. Ik kom er toch al niet onder uit in een extra paragraaf eerst nog iets over de relatie tussen leerstof en vraagvorm (meerkeuze, open-eind, essay) te zeggen.

In het volgende zal ik bij iedere heuristiek kort aangeven of deze zich in het bijzonder leent tot een bepaalde vraagvorm: voor essayvragen, meerkeuzevragen, of open-eindvragen. Welke vraagvorm je kiest hangt dan ook in de eerste plaats af van wat je wilt vragen. Dat is een ander uitgangspunt dan het tot nu toe gebruikelijke: dat je eerst een te gebruiken vraagvorm kiest op grond van vermeende algemene voor- en nadelen van de verschillende overwogen vraagvormen, en je dan ook aan die ene vraagvorm houdt. Bijvoorbeeld formuleren Stanley en Hopkins (1972) dat als volgt:

De verleiding bij het lezen van dergelijke teksten is groot om op basis van die algemene aanprijzingen de keuze te bepalen op bijvoorbeeld meerkeuzevragen als enige te gebruiken vraagvorm. Dan zit je vervolgens met het probleem hoe je relevante vragen over je leerstof in dat eenmaal gekozen procrustusbed moet wringen: er zal nogal eens stevig gekapt moeten worden. Lang niet alle zinvolle vragen over de leerstof zijn even goed in meerkeuzevorm als in openeindvorm te vragen. De voorbeelden daarvan liggen voor het opscheppen, en zal ik in het vervolg ook in zij het algemene termen, proberen te geven.

Wat dan wel de juiste weg is? Bekijk iedere te stellen vraag afzonderlijk, en ga na of bij deze bepaalde vraag een bepaalde vraagvorm het best past, en kies dan ook die vraagvorm als dat maar enigszins mogelijk is. Bepaalde vragen laten zich bijna vanzelfsprekend in het meerkeuzejasje gieten, terwijl andere vragen over misschien hetzelfde onderwerp zich bij uitstek lenen voor het korte essay type. Is het van belang dat de student bepaalde fouten heeft leren vermijden, dan kan het zinvol zijn hem meerkeuzevragen voor te leggen waarin de afleiders corresponderen aan resultaten of oplossingen die verkregen worden wanneer deze bepaalde karakteristieke fouten gemaakt worden. Gaat het om woordenkennis, dan ligt de openeindvorm voor de hand waarin de student het Nederlandse (of vreemde taal-) equivalent opschrijft. Eenvoudige rekenopgaven giet je natuurlijk niet in de vorm van meerkeuzevragen, maar geef je de openeindvorm: de student geeft het antwoord. Vraag je om bewijsvoeringen, dan kies je de essayvorm. Vraag je een werkstuk te maken, dan kun je dat ook als een essay-opgave beschouwen. Het correct aan kunnen geven of gegeven voorbeelden al dan niet tot een bepaald begrip behoren kun je uitstekend in de meerkeuzevorm doen, waar de alternatieven bestaan uit een opsomming van voorbeeld(en) en niet-voorbeelden.

Heel vaak zal zich de situatie voordoen dat er maar een klein aantal mogelijke antwoorden is waar de student in feite uit kiest bij het beantwoorden van een bepaalde vraag. Je kunt in zo'n geval dan ook de meerkeuzevorm gebruiken, waarin de afleiders bestaan uit die alternatieven. De raadkans die de student dan heeft zou hij ook hebben wanneer de openeindvorm gebruikt wordt, omdat ook dan er uit een klein aantal mogelijkheden gekozen wordt. Een triviaal voorbeeld is de vraag naar de hoofdstad van Gelderland, de ontdekker van de penicilline, de diagnose bij een gegeven ziektebeeld.

Ik behandel hier niet de voordelen en nadelen die bepaalde vraagvormen in het algemeen hebben, afgezien van de stof die terug gevraagd wordt (zie daarvoor elders in deze cursus). Wel geef ik een kort overzicht van de meest gebruikte vraagvormen.

| essay, casus, werkstuk, | Iedere vraag wordt beantwoordt met een uiteenzetting; die kan lang zijn (het opstel), of korter (de toets bestaat uit een aantal essayvragen of opgaven). |

| open-eind, ook wel kort antwoord vragen, soms invul vragen | vragen die met een enkel woord, getal, of met een korte zin te beantwoorden zijn (en ook moeten worden). |

| juist/onjuist, of ja/nee vragen | aangegeven moet worden of de uitspraak die in de vraagstelling gedaan wordt juist of onjuist is. |

| meerkeuze vragen | bestaan uit de vraagstelling, ook wel de stam van de vraag of van het item genoemd, en twee of meer alternatieven waarvan het meest juiste aangestreept moet worden, of de juiste gekozen moet of moeten worden (er zijn vele varianten mogelijk, waarbij er voor te zorgen is dat de student goed ingespeeld is op het soort te stellen meerkeuzevragen). |

De vragen uit een schriftelijke toets zijn in dezelfde vorm natuurlijk ook mondeling te stellen; of een toets mondeling of schriftelijk wordt afgenomen hoeft dan ook in dit opzicht niet noodzakelijk verschil uit te maken. In de praktijk worden vragen voor mondeling echter niet tevoren opgesteld, laat staan dat er een gedetailleerd draaiboek van tevoren is vastgelegd voor de gesprekken, zodat dit meer ongestructureerde mondeling zo zijn eigen bijzondere problemen kent, waarop ik elders in deze cursus nog verder zal ingaan.

Deze benadering, de te kiezen vraagvorm af laten hangen van de specifieke te stellen vraag, kan ertoe leiden dat een toets bestaat uit verschillende vraagvormen naast elkaar. Daar hoeft geen bezwaar tegen te bestaan, als je er maar voor zorgt dat de presentatie overzichtelijk is, dat de meerkeuzevragen bij elkaar staan, evenals de open-eindvragen, de essayvragen. Praktische probleempjes kunnen zich natuurlijk wel voordoen, maar zijn ook eenvoudig op te lossen: bijvoorbeeld wanneer de keuzeantwoorden automatisch gescoord worden, en de essay antwoorden door meerdere beoordelaars afzonderlijk na te kijken zijn. Over de puntentelling voor vragen van verschillende vorm zijn tevoren natuurlijk duidelijke afspraken met de studenten gemaakt.

Nu kan het zijn dat de praktijk sterker is dan de leer, dat het aantal studenten zo groot is dat bij voorkeur van geautomatiseerde toetsverwerking gebruik gemaakt wordt, en er dus meerkeuzevragen gebruikt worden. Dat mag dan zo zijn, dan is het toch raadzaam bij de leerstofanalyse en een eerste aanzet tot vraagformulering te beginnen met de vragen te formuleren in de vorm die als vanzelfsprekend bij de stof en de bedoeling van de vraag past, om later eventueel te proberen het compromis te construeren waartoe de omstandigheden van de toetsing soms kunnen dwingen. Wetend dat het gebruik van meerkeuzevragen een praktisch compromis is, is het beter mogelijk om al te onzinnige formuleringen te voorkomen. Juist bij het zoeken naar 'afleiders', foute alternatieven, voor zijn meerkeuzevragen loopt de docent het gevaar dat de student keuzes worden gevraagd die in het onderwijs helemaal niet aan de orde zijn geweest, en eigelijk ook niet tot de doelstellingen horen.

Het idee studenten 'af te leiden' is een vorm van didactiekpathologie. In deze cursus zal ik het woord 'afleider' niet vervangen door 'fout antwoord' of iets dergelijks, ik zal deze zonde uit 1979 niet verbloemen. In de in 2006 begonnen herziening 'Toetsvragen ontwerpen' komt het woord 'afleider' maar een enkele keer voor: om voor dit misbruik te waarschuwen. Ik wijs er nadrukkelijk op dat het hier niet gaat om alleen maar een fijnzinnige nuance: het is dit soort misbruik van vertrouwen van studenten dat toetsen en examens bij hen in een kwaad daglicht stelt.

Vrijwel ieder begrip dat de moeite van het onderwijzen waard is, is rijk aan inhoud: vaak kunnen talloze voorbeelden of toepassingen bedacht worden. Dat heeft als prettige bijkomstigheid dat een vraag over een bepaald begrip waarin een voorbeeld of toepassing van dat begrip aan de orde is, zich makkelijk laat herformuleren tot een nieuwe vraag door alleen maar een ander voorbeeld of een andere toepassing te kiezen.

Het aantal gehele getallen onder de 10 is maar beperkt. Wanneer je echter een optelvraag construeert waarin de leerling twee getallen onder de tien bij elkaar op moet tellen, dan zijn er 36 varianten op deze zelfde vraag mogelijk door de in te vullen getallen (voorbeelden van het begrip 'gehele getallen onder de 10)' te variëren. Dat lijkt een beetje een al te simpel voorbeeld, maar toch geeft het de bedoeling heel erg goed weer. Een dergelijke vraag zonder concrete getallen (zonder concrete voorbeelden) wordt in de toetsliteratuur ook wel een item form genoemd.

Ook bij ingewikkelder begrippen, wetten, technieken, etcetera kan de item form gebruikt worden.

Op deze wijze kan bij iedere vraag die bij een bepaald begrip geconstrueerd wordt, wanneer toepassingen of voorbeelden daarin een rol spelen, een aanzienlijke reeks nieuwe vragen met weinig moeite gemaakt worden door alleen maar de toepassingen of voorbeelden te variëren.

Wat doe je nu met een reeks vragen die allemaal hetzelfde zijn behalve het daarin concreet ingevulde voorbeeld of de gegeven toepassing?

Ik heb tot nog toe een beetje impliciet gelaten wat ik nu duidelijk wil stellen: de vragen in een toets op te nemen zullen meestal nieuwe vragen moeten zijn, vragen die de student in precies deze vorm of aankleding niet eerder onder ogen heeft gehad. De idee hierbij is dat begripsmatig leren moet betekenen dat de student in situaties die hij niet eerder gezien heeft met het geleerde begrip moet kunnen werken. Of negatief geformuleerd: het kan als regel niet de bedoeling zijn dat de student leerstof (en vragen over die stof) louter uit het hoofd leert; het kan ook niet de bedoeling zijn dat toetsvragen letterlijk de stof terugvragen, of letterlijk gelijk zijn aan in het onderwijs besproken en geoefende vragen.

De vraag is dan: hoeveel verschil is genoeg verschil om van een 'nieuwe' of onbekende vraag te kunnen spreken? Bloom en de zijnen in hun oorspronkelijke werk over een cognitieve taxonomie voor onderwijsdoelstellingen (1956, blz. 125) hielden zich ook met die vraag bezig, en kwamen na het afstrepen van enkele minder reële mogelijkheden tot de formulering dat in de toets een goede (toepassings) vraag een probleem moet behelzen dat als zodanig aan de student bekend kan zijn, maar dat stelt op een manier waar de student waarschijnlijk nog niet eerder aan gedacht zal hebben ('a problem known to the student but a new slant that he is unlikely to have thought of previously). Bloom c.s. konden hier kennelijk nog niet tot klaarheid komen, hun formulering blijft vaag, en ook in de door hen gegeven voorbeelden is op generlei wijze iets van de item-forms-benadering al te herkennen. Want zo moet je 'bekende problemen vanuit een nieuwe invalshoek, zien: de aard en eventueel ook de formulering van de vraag blijft hetzelfde, wat verandert is het voorbeeld of de toepassing die in die formulering genoemd wordt.

In de literatuur is de item-forms-aanpak bij uitstek geprobeerd door onderzoekers die zich interesseerden in automatisering van de toetsvragen constructie, de vraag of je computerprogramma's zou kunnen opstellen die een grote hoeveelheid vragen op basis van gespecificeerde item forms zouden kunnen genereren. Nu is dat, behalve in enkele speciale en eenvoudige gevallen, nog niet gelukt, maar dat betekent niet dat deze zelfde item-forms-aanpak voor de docent die zijn eigen toetsvragen jaarin jaaruit moet maken niet bijzonder handig zou zijn (zie o.a. Smal 1977 en Hamaker en Wouters 1975 m.b.t. automatiseringspogingen).

Item forms zijn dus een bijzonder krachtig hulpmiddel bij het snel en efficiënt maken van vragen met een tot in hoge mate gecontroleerde kwaliteit. Het grote probleem is natuurlijk hoe je in de eerste plaats aan de formulering van het item form zelf komt, en daarvoor wil ik de heuristieken hierna en in het volgende hoofdstuk gegeven, van harte aanbevelen.

Ik heb de te behandelen heuristieken geordend rond wat er in de stam van de vraag als gegeven is opgenomen, en wat er van de student gevraagd wordt. Bijvoorbeeld kan in de stam van de vraag het betreffende begrip genoemd worden en van de student een illustratie of toepassing daarvan gevraagd worden:

Het begrip dat in de stam van de vraag genoemd wordt is de 'kwadratuur van de cirkel'. En dat is ook wat van de student gevraagd wordt: de methode daarvoor aan te geven. Het voorbeeld is een strikvraag, en daar moet je studenten niet mee plagen in een toets.

Het gaat hier om het thuis kunnen brengen, identificeren, herkennen van voorbeelden van een met name genoemd begrip, en dus ook het als zodanig kunnen 'ontmaskeren' van niet-voorbeelden van dat begrip.

Het begrip waar het in het voorbeeld om gaat is 'genetisch evenwicht,' waarvan a) t/m f) een aantal voorbeelden en niet-voorbeelden zijn; de student streept alleen de voorbeelden aan. Het voorbeeld is een meerkeuzevraag, met een wat groter aantal alternatieven dan gebruikelijk, waarbij bovendien meerdere alternatieven als 'juist' aangestreept kunnen (moeten) worden.

Niet altijd zal het onderscheid tussen wat nog wel, en wat niet meer als voorbeeld bij een bepaald begrip past even duidelijk of even makkelijk te trekken zijn. Ik zal op de hiermee samenhangende problematiek ingaan in paragraaf 3.1

Deze heuristiek 2.3.1 staat erg dicht bij de leerstof, erg dicht ook bij de wijze waarop begrippen in het onderwijs behandeld, geoefend, bestudeerd zullen zijn. Het zullen veelal 'makkelijke' vragen blijken te zijn, die daarom niet minder relevant hoeven te zijn. Of voor uw eigen vak dit soort heuristiek goed van pas komt? Dat hoeft zeker niet altijd het geval te zijn, de beslissing is aan u zelf.

Vanzelfsprekend worden nieuwe, in literatuur en onderwijs niet behandelde, voorbeelden en niet-voorbeelden, als alternatieven gekozen. Daar zit hem juist de crux van het onderwijs: begrippen leren hanteren in nieuwe situaties, situaties die als zodanig niet in het onderwijs zijn behandeld, maar waar de begrippen op passen. Ik geef nog enkele voorbeelden.

De beide laatste voorbeelden zijn vragen waarbij de student weet dat precies één alternatief (het meest) juist is. Je kunt aan deze vorm van meerkeuzevraag gebonden zijn omdat anders de antwoordformulieren niet automatisch te scoren zijn, maar het is dan toch wel erg inefficiënt: gebruik dan liever de ja-nee-vorm, dat scheelt de tijd nodig om al die extra alternatieven te lezen en daarover na te denken.

Ik heb overigens bij het nakijken van verschillende tekstboeken maar weinig vragen kunnen vinden die op deze heuristiek passen. Misschien komt dat doordat bij de behandeling van de leerstof (te) weinig accenten gelegd worden op een goede afbakening van de behandelde begrippen, misschien wordt wat al te makkelijk aangenomen dat alleen een definitie van besproken begrippen voldoende is om de student ook in bijvoorbeeld toepassingsproblemen met deze begrippen uit de voeten te kunnen laten komen. Ik kom daar straks nog op terug. Het kan ook zijn dat vragen naar deze heuristiek geconstrueerd relatief 'makkelijk' blijken te zijn, en daarom (overigens niet vanzelfsprekend terecht) uit de toetsing worden weggelaten.

Er is een grote verwantschap tussen deze heuristiek en de heuristiek in de laatste paragraaf besproken. Was daar het te maken onderscheid dat tussen voorbeelden en niet-voorbeelden, hier gaat het om het kunnen herkennen van juiste en onjuiste toepassingen, of om het kunnen vermijden van bepaalde karakteristieke fouten bij toepassing van een genoemde regel, techniek, wet, formule. Meestal zal de toepassing in een ook in de vraag aangegeven situatie moeten gebeuren, of met aangegeven materialen, of met gebruik van gegeven cijfers. Deze verdere gegevens moeten misschien eerst door de student nog bewerkt, geordend of geanalyseerd worden voordat ze 'toepassingsrijp' zijn, in welk geval de vraag moeilijker zal zijn dan wanneer die extra activiteit niet gevraagd wordt. Heuristiek 2.3.2 lijkt vooral van belang voor leerstof waar het er om gaat het inadequate gedrag van de student te vervangen door correct gedrag, voor vraagstukken waar de slecht geïnformeerde student geneigd is verkeerde technieken op toe te passen, en leerstof die nogal tegenintuïtief van karakter is (waar leek en deskundige anders of zelfs tegengesteld tegenaan kijken).

De voor de hand liggende vraagvorm is hier de meerkeuzevraag, waar in de stam van de vraag de regel, formule, wet, techniek, etcetera met name genoemd wordt, eventueel de toepassingssituatie beschreven wordt, en de alternatieven bestaan uit één juist (eventueel meerdere juiste wanneer meerdere oplossingen juist kunnen zijn) alternatief, en de overige alternatieven de oplossingen zijn die verkregen worden wanneer de student een bepaalde karakteristieke fout maakt (die hij juist in het voorafgaande onderwijs heeft leren vermijden, als het goed is).

Dit voorbeeld heeft erg veel weg van het in de vorige paragraaf gegeven voorbeeld over 'genetisch evenwicht'. Dat is een klein beetje met opzet, als demonstratie van het meer graduele dan categorische verschil tussen 'voorbeelden' en 'toepassingen'.

Dit voorbeeld betreft een open-eindvraag; er wordt van de student een kort geformuleerd antwoord verwacht. De toegepaste techniek die hier 'getoetst' wordt is de variantieanalyse, en niet de wijze waarop homogeniteit van varianties onderzocht wordt. Je ziet dat in dit voorbeeld meerdere 'begrippen' tegelijk aan de orde zijn, in hun specifieke onderlinge relatie; dat het accent ligt op het onderkennen van een manco in de uitvoering van de variantieanalyse, maar dat tegelijk dat manco ook met name door de student genoemd moet kunnen worden.

Het laatste voorbeeld is in hoge mate toegesneden op hetgeen ook later in studie zowel als beroep van belang is: het als vanzelfsprekend kritisch beschouwen van gerapporteerde data-analyses, waar auteurs met naam en toenaam de gebruikte techniek specificeren maar het aan de lezer is om af te checken of de techniek ook correct is toegepast. De heuristiek kan dan ook niet alleen het herkennen van goede toepassingen betreffen, maar ook het aangeven van omissies of het identificeren van gemaakte fouten.

Het gaat hier om gevraagde (nieuwe) toepassingen van een met name genoemde techniek, wet, regel, etcetera

Het zal bij dit soort vragen vaak gaan om een hint, een concrete aanwijzing op welke wijze het gegeven probleem opgelost kan worden. Dat bespaart de student het zoeken naar de te gebruiken techniek of wetmatigheid. Dat spitst de aard van de vraag toe op de vaardigheid in het toepassen van de betreffende techniek of wet of regel. Het gaat er niet om dat de student kan onderkennen dat hij in het gegeven probleem deze bepaalde techniek moet aanwenden. Het kan ook zijn dat het gaat om een beperking, een randvoorwaarde of een handicap die bij de oplossing van het gegeven probleem in acht genomen moet worden. Terwijl het hierboven gegeven voorbeeld om niets méér vraagt dan regelrechte toepassing van een techniek.

Het gaat hier om een zinvolle en bruikbare soort vraagstelling. Het ligt voor de hand om open-eindvragen te gebruiken, eventueel kort essay. Werkstukken hebben van nature al een essay karakter.

Ook hier geldt weer dat misschien van belang is dat de student bepaalde karakteristieke fouten heeft leren vermijden, in welk geval ook meerkeuzevragen bruikbaar zouden kunnen zijn; het gaat dan om vragen met als alternatieven de uitkomsten verkregen onder correcte toepassing van de gegeven regel of techniek, en uitkomsten verkregen wanneer bepaalde karakteristieke fouten gemaakt zouden zijn. Dan blijft de meerkeuzevraagvorm nog een compromiskarakter behouden: kennelijk gaat het hier om objectief scoorbare antwoorden (bij rekenopgaven bijvoorbeeld), dus waarom zou je dan meerkeuzevragen gaan gebruiken, met de daaraan inherente raadkansen voor studenten met op dat specifieke leerstof onderdeel een achterblijvende beheersing?

Bij de meeste toepassingen zul je te maken hebben met een situatie waarin of waarop de toepassing plaats moet vinden, met gegevens waarvan gebruik gemaakt moet (of eventueel kan) worden, met materialen die gebruikt moeten of mogen worden. Van belang voor de moeilijkheid van de vraagstelling is dan de aard van de gegevens, te gebruiken materialen, situatiebeschrijving e.d.

Zo is het mogelijk de student de gegevens die hij in de formule heeft in te vullen op een presenteerblaadje aan te reiken, maar je zou ook een verhaal kunnen geven waaruit de student moet zien de relevante gegevens te halen, of te vertalen. Voorbeelden daarvan zijn ingeklede vergelijkingen of redactiesommen.

Redactiesommen zijn in de geschiedenis van de wiskunde, overal ter wereld, altijd uitbundig gebruikt, maar in de 20e eeuw ook stevig onder vuur komen te liggen. In mijn herziening 'Toetsvragen ontwerpen' is er meer aandacht voor de ontsporingen bij redactiesommen. Een markante didactische ontsporing is dat leerlingen ervan leren dat je 'iets' met de gegeven getallen moet doen, ook wanneer dat evident niet tot een gepast antwoord op de gestelde vraag leidt. (Een schip heeft 25 koeien en 10 geiten aan boord. Hoe oud is de kapitein?)

Deze vraagvorm staat heel dicht bij de vorige: los op met behulp van, demonstreer, e.d. Wil deze vraagvorm enige zin hebben, dan moet het kunnen geven of genereren van nieuwe eigen voorbeelden een relevante wijze van omgaan met het betreffende begrip zijn. En dan blijven we eigenlijk in de toepassingssfeer zitten: vragen van het type: maak ... , speel ... , construeer ... , bedenk ... , teken ... . Of, wat minder stroef geformuleerd, moet de student het bedenken van nieuwe voorbeelden op kunnen vatten als een relevante bezigheid.

De vraagsoort is hier nogal strikt beperkt tot open eind en essay; meerkeuzevragen komen niet in aanmerking omdat door het voorgeprogrammeerde karakter van deze vraagsoort er geen ruimte is voor het zelf bedenken van nieuwe voorbeelden.

Deze vraagvorm is een beetje riskant, omdat je vaak niet kunt weten of het antwoord van de student echt door hem op het moment van de toetsing bedacht is: misschien heeft hij zich goed op de toets voorbereid en thuis al nieuwe voorbeelden bedacht die hij nu eenvoudig uitschrijft; misschien heeft hij zich breder in de literatuur georiënteerd dan alleen in het opgegeven tekstboek en kan hij daaruit putten naar nieuwe voorbeelden. Het lijkt me dat in nogal wat praktische situaties de docent dit risico best kan aanvaarden. Wil hij dat niet, dan is deze vraagvorm waarschijnlijk toch bruikbaar voor oefening, practicumopgaven, of eventueel take-home-toetsen. In de laatste gevallen gaat het dan minder om 'toetsing' als wel om 'oefening.'

De voorbeelden liggen voor het oprapen. De student rechten zou casus kunnen bedenken die mogelijk passen bij een gegeven rechtsregel; de student statistiek kan concrete problemen bedenken die met een gegeven techniek aangepakt kunnen worden; nieuwe illustraties, eventueel voorbeelden uit het dagelijks leven, van een gegeven natuurwet; etcetera.

Alleen begrippen die uit een klein aantal 'leden' bestaan lenen zich minder voor deze vraagvorm. Ik denk daarbij aan bovengeschikte categorieën waarvan alledaagse voorbeelden zijn: meubels, fruit, voertuigen. De opsomming van categorieën die hieronder vallen is al gauw min of meer volledig: stoelen, tafels, banken, kasten, putten de categorie 'meubels' al aardig uit, en nog meer voorbeelden vragen is meer een vorm van intelligentietesterij (slimmigheid) dan het toetsen van het weten om te gaan met het begrip 'meubel.' (Zie ook Rosch en Mervis, 1975).

Het gaat hier om de variaties op 'gegeven deze naam (van bepaald begrip), geef een andere naam.' Geconcretiseerd wordt dat dan: geef een ander woord voor .... ; geef vertaling van .... ; geef technische term voor .... .

Deze heuristiek kan van belang zijn voor onderwijs waar de beheersing van een basisvocabulaire van vreemde taal of van technische terminologie gewenst is. Daarbij gaat het om vrijwel perfecte vaardigheid in het hanteren van synoniemen, vertalingen, etcetera, althans in het kunnen omgaan met het woordenboek.

De verdere toepasbaarheid van deze heuristiek is gering. Het gaat om nogal primitieve associatieve kennis, van het makkelijk in het hoofd te stampen, maar o zo snel weer vergeten soort. Het kan soms nodig zijn dat de student over dit soort associatieve kennis beschikt om daarmee andere studieopgaven te vergemakkelijken. Dan zou je tussentoetsjes kunnen hebben waarin deze vraagsoort voorkomt. Voor eindtoetsen, waar alleen de einddoelstellingen van het onderwijs aan de orde zijn, zal deze vraagsoort slechts zelden een terechte plaats hebben.

Voorbeelden zijn vanzelfsprekend genoeg om ze hier weg te kunnen laten. De voor de hand liggende vraagvorm is open-eind; afwijken daarvan ten gunste van de meerkeuzevorm geeft al snel wanstaltige vragen, waarvan twee voorbeelden:

Let ook op het onzinnige alternatief d) in het eerste voorbeeld, kennelijk gekozen om ondanks het niet kunnen bedenken van een behoorlijk alternatief toch aan het vierkeuze schema te kunnen voldoen.

Er zijn gevallen waarin de meerkeuzevorm wel bruikbaar kan zijn, wanneer karakteristieke fouten in het onderwijs zijn behandeld, en de leerling die heeft leren vermijden. In dat geval kun je dergelijke 'fouten' als 'afleiders' in meerkeuzevragen gebruiken. Denk aan 'Schwere Wörter', 'Mots et tournures difficiles.'

Hoe belangrijk definities (of formules) ook mogen zijn, het is meestal zinloos deze uit het hoofd te kennen, maar niet in staat te zijn in reële situaties met het begrip, de wet, etcetera om te gaan. Wordt bij toetsing gevraagd definities, formules, uit het hoofd te kennen dan wordt een premie gezet op het uit het hoofd leren daarvan ten koste van misschien belangrijker andere vaardigheden.

Ook in disciplines waar definities of formules een belangrijke rol spelen gaat het om het kunnen-werken-met-definities of formules, en is de toetsvraag ook op dat kunnen-werken-met af te stemmen.

Sommige definities, zoals waarschijnlijk ook die uit het gegeven voorbeeld, kunnen door studenten heel goed toegepast worden zonder dat zij eerst de definitie hoeven na te slaan. Het is zelfs niet ondenkbaar dat studenten die de toepassing vrijwel perfect beheersen in verwarring gebracht zouden worden door de vraag om de definitie (of de formule) te reproduceren. Andere definities of formules zijn complexer, en de student die bij toepassingen zeker van zijn zaak wil zijn zal, als het even kan, niet afgaan op zijn geheugen, maar de definitie of de formule opzoeken in boek, syllabus, aantekeningen, glossarium, of de bij de toets verstrekte hand-out. Het is wenselijk om de student bij het afleggen van de toets in de gelegenheid te stellen deze informatie snel na te slaan, al was het alleen maar om te vermijden dat belangrijke opgaven fout gemaakt worden door op zich makkelijk te vergeven vergissingen bij het zich herinneren van daarbij nodige definities of formules.

Het is zelden zinvol dat de student goede definities kan onderscheiden van foutieve definities. Vraag daar dan ook niet naar, hoe groot de verleiding misschien ook is om een hierop gerichte meerkeuzevraag te construeren (want dat gaat heel erg makkelijk).

Gaat het om begrippen waar ongeveer evenveel definities van in omloop zijn als er auteurs van studieboeken zijn, dan kan ik niet anders dan uitspreken dat het kennen van de definitie papegaaienkennis is, en het leren ervan verkwiste tijd.

In het algemeen is deze vraagsoort dus te vermijden.

Het vragen van een beschrijving in eigen woorden is voor een eindtoets geen zinvolle vraagstelling. Bij mondelinge ondervraging zou zo'n vraag gebruikt kunnen worden om het gesprek op gang te helpen.

De bezwaren zijn gedeeltelijk dezelfde als die tegen het vragen van definities. Daarbij komt nog dat, waar er ruimte is voor het in eigen woorden formuleren, er ook ruimte is voor subjectieve beoordeling van die gegeven beschrijving-in-eigen-woorden.

Bij het bestuderen van de stof is het verstandig om voor jezelf die stof nog eens te herformuleren. Hoe verstandig ook, toch is dat een studiegewoonte die enig risico in zich kan bergen, afhankelijk van de wijze waarop de docent de stof 'terug vraagt'. In een onderzoek in vier studierichtingen in Leiden vonden Crombag, Gaff, en Chang (1976) dat de gewoonte leerstof in eigen woorden te formuleren vaker voorkwam bij zwakkere (blijkens de studieresultaten) studenten. Het gaat hier om &én schaaltje uit een studiegewoontenvragenlijst, het enige schaaltje ook waarop (statistisch significant) verschillend gescoord werd door studenten die geslaagd, respectievelijk gezakt waren voor het propedeutisch examen. De onderzoekers merken hierbij op:

De voorgaande vraagvormen hebben met elkaar gemeen dat in de vraagformulering of in de stam van de vraag aangegeven wordt om welk begrip het gaat, welke techniek of formule toe te passen is, en dergelijke. Lang niet altijd hoeft met naam en toenaam aangegeven te worden welke techniek de student kan toepassen om het probleem op te lossen, omdat op andere manieren het de student duidelijk kan zijn om welke techniek, begrip etcetera het hier kennelijk gaat. Denk alleen maar eens aan het toetsje dat een klein onderdeel van de stof, een bepaalde paragraaf van het boek, afsluit: de opgaven gaan evident over technieken die in dat stukje stof behandeld zijn.

De laatste observatie is ook om een andere reden van belang. Wanneer de stof opgedeeld wordt in kleinere, ook afzonderlijk getoetste onderdelen, wordt er een sterke koppeling gelegd tussen de vragen en het voorafgaande stukje stof. De student hoeft niet lang te zoeken naar de geschikte methode of techniek om een gesteld probleem te lijf te kunnen: die kan hij vinden in de zojuist door hem bestudeerde stof. Dat betekent dat de vragen in zo'n deeltoets relatief makkelijk zullen zijn. En dat je mag verwachten dat dergelijke vragen in de eindtoets moeilijker kunnen zijn, doordat nu de directe koppeling met bepaalde gedeelten van de stof verbroken is, de student wat meer zal moeten zoeken en daarbij het risico loopt niet te zullen vinden.

Het is eenvoudig in te zien dat opgaven in een eindtoets al gauw erg moeilijk kunnen worden wanneer van de student gevraagd wordt om meerdere begrippen of technieken in combinatie te hanteren om het gestelde probleem op te lossen, zonder dat expliciet aangegeven wordt welke technieken etcetera hij kan of moet gebruiken.

Tenslotte kan door oefening er een dermate sterk associatief verband gelegd worden tussen bepaalde soorten probleemstelling en de daarbij te gebruiken technieken, dat het noemen van de te gebruiken techniek rustig achterwege kan blijven zonder daardoor de opgave moeilijker te maken.

Het gaat hier nog niet om determineren, classificeren en dergelijke, waar voorbeelden van verschillende begrippen uit elkaar gehouden moeten kunnen worden (zie hoofdstuk 3 daarvoor).

Hebben we te doen met voorbeelden van toepassingen, dan gaat het om vragen als:

Gaat het niet zozeer om geïllustreerde toepassingen maar meer om gegeven objecten of gebeurtenissen, dan wordt deze vraagvorm wat lastiger doordat ze al makkelijk ambigu van karakter kan worden. Mogelijk geeft de student andere antwoorden dan de docent bedoelde, maar toch antwoorden die op zich niet fout hoeven te zijn. De meeste objecten en gebeurtenissen horen namelijk tot meerdere begrippen of categorieeën. Een voorbeeld is het begrip 'ecosysteem', waar een vijver toe behoort, een wei, tuinkas, en dergelijke. Vraag je nu omgekeerd tot welke bovengeschikte categorie een vijver behoort, dan kun je vele verschillende antwoorden verwachten, die waarschijnlijk alle als goed aangemerkt moeten worden, en misschien wordt het bedoelde 'ecosysteem' dan maar weinig genoemd. Een mogelijke oplossing voor het gesignaleerde probleem ligt voor de hand: geef meerdere voorbeelden, en vraag naar het hoger geordende begrip, de bovengeschikte categorie, of hoe dat ook maar genoemd mag worden.

Een andere manier om de ambiguïteit te vermijden is in de stam van de vraag min of meer te omschrijven welk antwoord je verwacht:

De vraagsoort die hier op goede wijze bij past, is die van de open-eindvraag, of de kort-antwoordvraag. Bij het scoren van de antwoorden is het wél zaak te letten op antwoorden die mogelijk goed te rekenen zijn, hoewel de docent het antwoord niet in het scoringsvoorschrift had opgenomen (eenvoudig niet aan gedacht). Meerkeuzevragen zullen veelal niet geschikt zijn. Ik geef daar een voorbeeld van.

Een onzinnig item, rare alternatieven. Het is bij deze vraagvorm nu eenmaal moeilijk om onjuiste alternatieven te vinden die niet onnatuurlijk zijn, er met de haren bij gesleept, of van de vraag geen strikvraag maken. Het gegeven voorbeeld illustreert nog een ander gevaar, een sluipend gevaar dat de niet gewaarschuwde docent voortdurend bedreigt: in plaats van een behoorlijke omschrijving van een levensecht voorbeeld, of tenminste iets dat best levensecht zou kunnen zijn, staat er in de stam van de vraag een algemene beschrijving die past op alle voorbeelden, je zou kunnen zeggen: het meest algemeen geformuleerde voorbeeld. Of gewoon: een beschrijving van het bedoelde begrip. De vraag toetst niet meer of de student een voorbeeld van het bedoelde begrip kan herkennen, maar of hij de beschrijving van het begrip herkent. En dat is iets heel anders. Dat is een verbaal kunstje, dat betekent niets, dat is vervelend en demotiverend. Het vervelende is nu dat veel toetsvragen, de meeste toetsvragen, waarschijnlijk onbedoeld verwaterd zijn tot dergelijke geestelijke manipulaties met verbaal materiaal, waar de leerstof toch in eerste instantie wel degelijk over reële, concrete, waarneembare objecten en verschijnselen gaat. Bekijk je een boek als dat van Mouly en Walton, waar het gegeven voorbeeld uit afkomstig is, dan zie je dat vrijwel alle items zich bevinden op dat niveau van abstract verbaal van alles en nog wat 'weten', maar nergens de koppeling met de realiteit, de observaties, de dingen, de gebeurtenissen nog aanwezig is.

Over juiste formulering van definities, over meer en minder correcte beschrijvingen van begrippen, en dergelijke vallen heel wat aardige vragen te bedenken, die echter onderwijskundig, om dat lelijke woord maar weer eens te gebruiken, te verfoeien zijn.

| uitspraak | voorwaarde |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Het bovenstaande is een mooi voorbeeld van een wat onconventioneel soort meerkeuzevraag, maar daar houdt de lovende commentaar dan ook wel op. Dit zijn gymnastische taaloefeningen die van de student gevraagd worden, dat heeft weinig of niets met natuurkunde te maken zou ik zeggen. De student die dit soort vraagstelling goed weet te beantwoorden kan nog met de mond vol tanden staan wanneer hij in een alledaags probleempje eens in de gelegenheid zou zijn het 'geleerde' 'toe te passen', gesteld al dat hij in staat zou zijn in dat alledaagse probleempje het algemene beginsel te herkennen dat hij zo fraai uit de boekjes geleerd had. Goed, ik chargeer, beste lezer. Maar het is ook wel bedroevend, vooral ook omdat dit voorbeeld verre van het enige in zijn soort is.

Tenslotte de belangrijke categorie vragen waar de student een opgave gesteld wordt, en hem gevraagd wordt om de juiste techniek, regel, wet, etcetera voor dit probleem te vinden en te gebruiken voor het bereiken van het gevraagde resultaat. Welke techniek, regel, of wet te gebruiken ligt niet direct voor de hand, is niet 'impliciet gegeven'. Wil de student met succes deze vragen te lijf kunnen, dan zal zijn beheersing van de gevraagde technieken etcetera van dusdanige kwaliteit zijn dat hij in staat is opgave en bruikbare techniek aan elkaar te koppelen. Hij moet de techniek, formule, wet, etcetera voldoende beschikbaar hebben in zijn geheugen, hij moet zelf op het idee kunnen komen de gevraagde techniek ook te proberen. Het is duidelijk dat dit soort opgaven meer of minder 'moeilijk' worden naarmate de stof die door de toets bestreken wordt meer of minder uitgebreid is, veel of juist weinig verschillende technieken, formules etcetera bevat.

Het geven van voorbeelden is hier overbodig vanwege de grote vanzelfsprekendheid.

Niet helemaal vanzelfsprekend is welke vraagsoorten hier overwogen kunnen worden. In veel gevallen zal de open-eindvraagvorm, of het korte essay geschikt zijn. Gaat het om te fabriceren werkstukken dan is er geen keus: die hebben altijd een essay-karakter. Gaat het om rekenopgaven en dergelijke, dan zou je wanneer dat om andere redenen dringend gewenst is de meerkeuzevraagvorm kunnen gebruiken: gebruik dan wat willekeurige getallen als 'foute alternatieven', tenzij wederom in het onderwijs het leren vermijden van bepaalde fouten een belangrijk punt is, in welk geval uitkomsten die door dergelijke fouten verkregen worden als fout alternatief te gebruiken zijn. Het nadeel van meerkeuzevragen blijft dan dat er een raadkans geïntroduceerd wordt die anders, bij de open-eindvorm, vrijwel afwezig is, en dat de student in staat wordt gesteld door terugrekenen het juiste antwoord te lokaliseren en dat kan wel eens in niet al te zuivere verhouding tot de doelstellingen van je onderwijs staan.

Het zal in het onderwijs niet zelden gaan over intellectuele vaardigheden die te maken hebben met het kunnen hanteren van meerdere begrippen tegelijkertijd. Ik herhaal nog even wat ik in brede zin met 'begrippen' aanduid:

------------------------------------------------------------------------

'begrippen' zijn: regels ziektebeelden

(in ruime zin) wetten klassen

modellen taxa

theorieën procedures

paradigma's technieken

begrippen (in enge zin)

etcetera.

------------------------------------------------------------------------

Na het leren van, of oefening in, afzonderlijke begrippen zal het er nog al eens op aan komen dat de student vervolgens leert om deze verschillende begrippen van elkaar te onderscheiden, dan wel ze in combinatie met elkaar te gebruiken, voor het oplossen van problemen die hem in onderwijs- of beroepssituatie gesteld kunnen worden. Bij sommige disciplines zal daarbij eerder het accent komen te liggen op de snelheid waarmee de student dat kan, dan op de juistheid (wanneer de laatste als vanzelfsprekend wordt beschouwd), in andere vakken kan de nadruk veeleer liggen op het al dan niet vinden van een correcte oplossing, al is voor dat laatste misschien wat meer tijd en enig uitproberen nodig.

Onderscheiden of combineren van begrippen lijken twee geheel verschillende vaardigheden te zijn, zodat ik beide in afzonderlijke paragrafen zal behandelen.

Snelheid of correctheid (speed or power) is veel minder een essentieel als wel een praktisch onderscheid. Het hangt sterk van de aard van de leerstof en de daarover gestelde doelen af of het gaat om eenvoudige opgaven die vrijwel altijd goed gemaakt kunnen worden maar waarbij het er juist om gaat dat dan ook snel te kunnen, of dat je te maken hebt met moeilijke opgaven die niet altijd correct opgelost zullen kunnen worden en waar ruim tijd voor beschikbaar wordt gesteld. Het spreekt vanzelf dat snelheid of correctheid ook zijn stempel zal drukken op de aard van de toetsing: een sterk accent op snelheid kan ertoe leiden dat bij toetsing het in de eerste plaats van belang is hoeveel vragen de student in de beschikbare tijd heeft geprobeerd (en meestal ook goed gemaakt); meestal zal correctheid van voldoende belang zijn om er voor te zorgen dat de beschikbare tijd ruim genoeg bemeten is dat vrijwel alle studenten het opgegeven werk ook af kunnen maken.

Wie een aantal min of meer verwante ziektebeelden afzonderlijk heeft bestudeerd, de bijbehorende symptomen kent, en goed in staat is om bij een gegeven geval aan te geven of het een voorbeeld van een bepaald ziektebeeld is of niet, kan in grote moeilijkheden raken wanneer hij zonder 'hints' aan de hand van symptomen die hij in een bepaald geval waarneemt moet zien te geraken tot een correcte diagnose. In de wiskundige analyse doet zich iets dergelijks voor bij het evalueren van integralen: de student heeft een aantal afzonderlijke technieken bestudeerd en geoefend, en wordt vervolgens geconfronteerd met het omgekeerde geval waarin hij moet ontdekken welke techniek mogelijk bruikbaar is voor het evalueren van de hem voorgelegde integraal. (keuze van een 'verkeerde' techniek leidt vaak niet tot een oplossing). Het tweede voorbeeld is ook bedoeld om aan te geven dat zelfs in geformaliseerde disciplines onderscheidingsproblemen een belangrijke rol kunnen spelen. Scheidslijnen zullen niet altijd scherp te trekken zijn: een bepaalde techniek leidt tot een snelle en elegante oplossing, enkele andere zijn ook bruikbaar maar vragen veel werk, de overige leiden waarschijnlijk niet tot oplossingen.

Dat scheidslijnen tussen verschillende ziektebeelden niet altijd even duidelijk te trekken zijn, zal ook buiten medische kringen ruimschoots bekend zijn. Vage scheidslijnen zijn in het algemeen een kenmerk van natuurlijke categorieën, en veel disciplines hebben nu juist deze natuurlijke categorieën als hun object van studie, en daarmee ook als object van het onderwijs.

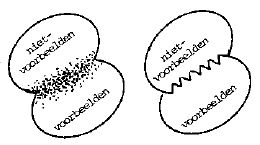

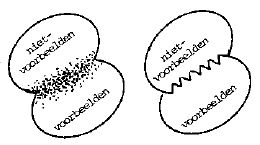

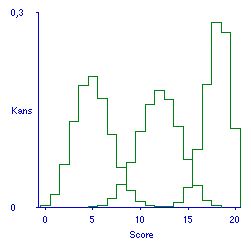

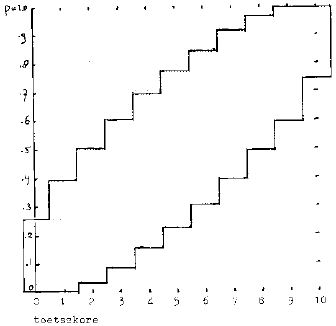

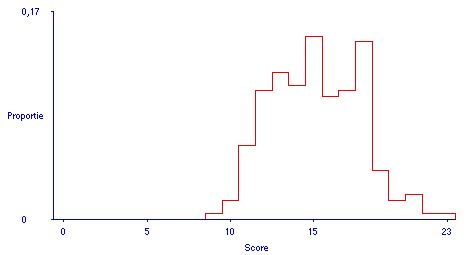

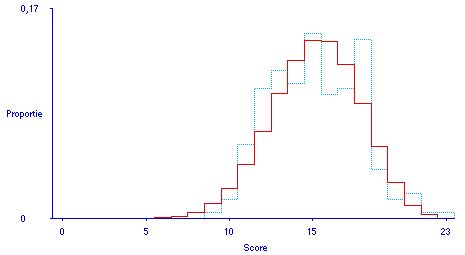

Deze vaagheid van natuurlijke categorieën is uiteraard ook al een probleem waar het gaat om het correct thuisbrengen van voorbeelden en niet-voorbeelden van een enkel begrip. Ik heb dat in figuur la aangegeven door een gestippeld scheidingsgebied in plaats van een scherpe lijn. Het kan zijn dat zo'n vaag of fuzzy overgangsgebied zich alleen maar voordoet in de ogen van de nog ongeoefende student: is dat het geval dan bestaat er kennelijk wel een duidelijke demarkatielijn maar kost het de nodige training om die te leren zien. Ik heb het laatste aangegeven door de zaagtand lijn in figuur 1b.

Heb je te maken met meerdere begrippen, dan kunnen deze om te beginnen *) van elkaar gescheiden zijn (figuur 2a), **) elkaar overlappen (2b), ***) of de een kan een subcategorie of speciale categorie van de ander zijn (2c). Ook in die gevallen kunnen scheidslijnen meer of minder fuzzy (2d) of moeilijk (2e) zijn.

Zie voor een recent overzicht: James A. Hampton (2007). Typicality, graded membership, and vagueness. Cognitive Science, 31, 355-384.

Zie voor filosofie en logica van vaag afgegrensde begrippen: Keefe, Rosanna, & Peter Smith (1996). Vagueness: A reader. The M.I.T. Press.

Voor de constructie van toetsvragen is het van belang om met dergelijke 'fuzzy' scheidingen tussen begrippen terdege rekening te houden. Al naar het belang dat aan het bestaan van die fuzzyness in het onderwijs wordt toegekend zal dat verschillend uitwerken. In het onderwijs zal benadrukt worden dat bepaalde onderscheidingen niet altijd scherp te maken zijn; dat niet altijd alle objecten, situaties, of gebeurtenissen éénduidig te classificeren zijn; dat sommige objecten etcetera méér prototypisch zijn voor een bepaald begrip dan andere objecten etcetera dat zijn; dat er op belangrijke punten soms moeilijk of geen overeenstemming tussen deskundigen te verkrijgen is over de betekenis van eenzelfde verschijnsel of onderzoekresultaat.

Juist vanwege dat gebrek aan eenduidigheid, ook in de beoordeling van vakdeskundigen, is het af te raden om in de toetsing vragen op te nemen die opereren in dergelijke fuzzy grensgebieden. Tenzij natuurlijk het kunnen werken met die fuzzyness tot de doelstellingen van je onderwijs behoort, denk aan gevallen waarin het van belang is die fuzzyness te leren onderkennen, en er mee te leren werken, bijvoorbeeld het stellen van een diagnose waarbij sterk rekening gehouden wordt met een alternatief dat niet uit te sluiten blijkt. Bij toetsvragen die opereren in fuzzy grensgebieden is het moeilijk om gegeven antwoorden op behoorlijke wijze als 'juist' of 'onjuist' te kwalificeren. Tenzij, zoals juist al aangeduid, van de student gevraagd wordt juist die fuzzyness aan te geven of te karakteriseren. In alle andere gevallen moet je vermijden onderscheidingen te vragen waar de ene beoordelaar van mening kan verschillen met de andere beoordelaar over de juistheid van beantwoording. Verschillen van inzicht zijn niet voorbehouden aan de deskundige beoordelaars, maar zijn ook de student toegestaan. Omdat de vraagconstructeur zich niet altijd even bewust zal zijn van de mate waarin zijn vragen zich in zo'n fuzzy grensgebied begeven, is het nodig om collega's bij de kwaliteitscontrole van de vragen nog voordat ze worden afgenomen, in te schakelen (zie ook hoofdstuk 5).

Het geschetste bijzondere karakter van natuurlijke categorieën, hun inherente vaagheid, krijgt pas de laatste jaren ook enige aandacht binnen de leerpsychologie (cognitieve psychologie). Studies op dit gebied zullen van belang zijn voor beantwoording van vragen hoe de natuurlijke categorieën uit dit vak op effectieve wijze in het onderwijs behandeld kunnen worden, en welke toetsingsvormen daarbij vooral geschikt zijn. Ik wijs op onderzoek van Norman en Bobrow (1979), Rosch (1973), Rosch en Mervis (1975), Klausmeier en Allen (1978), McCloskey en Glucksberg (1979), en het overzicht van Gagné (1978). In veel disciplines vindt met name ook onderzoek plaats gericht op het vinden van scheidslijnen, het afbakenen van categorieën, technieken voor classificatie en diagnose. bijvoorbeeld Lusted: Introduction to medical decision making (Springfield, Ill.: Thomas, 1968); Gregson: Psychometrics of similarity (London: Academie Press, 1975); Sneath en Sokal: Numerical taxonomy, the principles and practice of numerical classification (San Francisco: Freeman, 1973). De lezer zal het zelf aan kunnen vullen met relevante literatuur zijn eigen vakgebied betreffende. Deze complexere onderscheidingsproblematiek is bij de hier te behandelen heuristieken voor het construeren van toetsvragen natuurlijk niet direct aan de orde.

Bij dit soort opgaven moet de student correct kunnen classificeren, determineren, identificeren, etcetera, maar wordt het hem gemakkelijker gemaakt doordat aangegeven wordt uit welke alternatieven hij heeft te kiezen. Algemeen geformuleerde voorbeelden zijn:

In de praktijk wordt er nogal eens grof op papier bezuinigd door niet een concreet voorbeeld of een concrete situatie te geven, maar de probleemstelling in algemene termen te abstraheren. Dat is riskant, werkt uit het hoofd leren van teksten in de hand, vervreemdt de student van de stof, en bewerkt dat studenten die de stof verbaal goed beheersen later met concrete problemen niet goed uit de voeten kunnen. Hetzelfde verhaal geldt natuurlijk evenzeer voor vragen rond een enkel begrip, hoofdstuk 2. Ik leg er hier nog eens de nadruk op omdat ik bij het zoeken naar vraagvoorbeelden in met name onderwijskundige literatuur (Bloom et al 1956, Bloom et al. 1971, Mayer 1968, De Groot, Van Naerssen et al. 1975) geconstateerd heb dat meestal vragen in algemene termen gesteld worden, in plaats van op het concrete niveau waarin in studie en beroep de vragen op de student af zullen komen.

Het voorbeeld op de vorige bladzijde geeft een meerkeuzevraag, de vraagvorm waarop je onvermijdelijk uitkomt wanneer de alternatieven expliciet genoemd worden. Het kan zijn dat in bepaalde situaties de alternatieven waaruit gekozen moet worden impliciet gegeven zijn (bijvoorbeeld alle in een bepaald hoofdstuk behandelde technieken, classen, etc.), dan kan de open-eindvorm gebruikt worden; tegen de meerkeuzevorm bestaat dan echter geen enkel bezwaar, tenzij misschien het van belang is om deelnemers aan de toets die het onderwijs niet gevolgd hebben de wind uit de zeilen te nemen m.b.t. raadkansen. Wie de meerkeuzevorm wat magertjes vindt, kan uitbreiding zoeken in bijvoorbeeld een extra set alternatieven waar naar argumenten voor de gemaakte keuze(s) wordt gevraagd, zoals in het gegeven voorbeeld een aantal open-eindvragen werden toegevoegd.

Merk op dat in het gegeven voorbeeld alleen gevraagd wordt de correcte toets(en) aan te geven, niet om deze ook uit te voeren (waarvoor de precieze data in de probleemstelling ook ontbreken). Wie wil nagaan of de student een bepaalde toets correct kan uitvoeren, kan beter gebruik maken van een speciaal daarop toegesneden vraag, en een van de vraagsoorten uit hoofdstuk 2 gebruiken. Dat neemt niet weg dat het van belang is er voor te zorgen dat de student voldoende vertrouwd is met ieder van deze technieken afzonderlijk om vragen als deze niet te laten ontaarden in een woordenspelletje.

In het gegeven voorbeeld gaat het er om of de student de juiste alternatieven weet aan te geven, en is de snelheid waarmee hij dat kan van ondergeschikt belang.

Een voorbeeld waarin het wat meer op de snelheid van werken aankomt, waar iedere afzonderlijke techniek vrijwel perfect beheerst wordt en het er op aan komt trefzeker de juiste technieken voor het voorhanden liggende probleem te kiezen:

Evalueer met behulp van limiet stellingen

Dit is een open-eindvraag (drie open-eindvragen eigenlijk), de limietstellingen zijn impliciet gegeven, en behoren de student ook goed bekend te zijn. Eigenlijk is dit voorbeeld al een stap in de richting van de in paragraaf 3.2.2 te behandelen vraagvormen. Dat demonstreert nog weer eens dat de indeling in vraagvormen die ik hier geef niet formalistisch opgevat moet worden.

Dit is een variant op 3.1.1: de aangeboden probleemstelling bevat niet alle nodige informatie om de keuze tussen de aangeboden alternatieve diagnoses, categorieën etcetera te kunnen maken, en het is juist de bedoeling dat de student kan aangeven welke extra informatie voor die keuze nog nodig is. In algemene termen hebben we hier dan de volgende vraagvormen:

De vraagvorm genoemd bij het derde punt zou een dubbele meerkeuze kunnen zijn, of een open eind wat het eerste deel van de vraag (welke extra veronderstelling), en meerkeuze wat het tweede deel van de vraag (welke van de genoemde toetsen) betreft.

Niet altijd zal gevraagd worden dan ook de diagnose te stellen, tussen de categorieën te kiezen, etc.: in de regel heb je daar immers ook dat extra gegeven voor nodig, de uitslag van de extra test, etcetera Bij ingenieuze toetsprocedures zou je die extra informatie inderdaad tijdens de toetsafname kunnen verschaffen. Methoden daarvoor liggen voor de hand wanneer de toetsing plaats vindt aan de computerterminal. Is de toetsing schriftelijk, dan kan met speciale inkten gewerkt worden, die resultaten van door de student gevraagde tests en dergelijke zichtbaar maken. Ook geschikt is de 'tab item' techniek, waar de student plakkers verwijdert om extra informatie te verkrijgen, of verf wegkrabt. Voor beschrijving van deze tab-itemtechniek zie Fitzpatrick en Morrison, in Thorndike (1971) p. 248-250. Een voorbeeld van werken met speciale inkt die bij bewerking met een daarvoor meegeleverde viltstift het gedrukte zichtbaar laat worden, geeft het boek 'Clinical simulations; selected problems in patient management' van McGuire, Solomon en Forman (Appleton-Century-Crofts, 1976)

Wil deze vraagvorm zinvol, niet gekunsteld, zijn dan moet de hier gevraagde vaardigheid in onderwijs en beroepsuitoefening ook relevant zijn. Een waarschuwing die natuurlijk ook voor de andere vraagvormen geldt.

De problemen waar deze wereld ons mee confronteert plegen niet in voorgebakken vorm op ons bordje gelegd te worden. Er moet vaak eerst opgeruimd, geanalyseerd, geformaliseerd, geherformuleerd, geordend, voorbewerkt worden om vervolgens aan oplossingen, classificeren, behandelen, etcetera te kunnen gaan denken.

Hoe de vragen precies ingericht worden zal ook hier weer sterk van de aard van de stof afhangen. Gaat het om eenvoudige of routinematige bewerkingen van het aangeboden materiaal dan kun je misschien volstaan met te vragen de juiste alternatieven aan te geven (het best passende alternatief aan te geven). Gaat het om tamelijk uitvoerige bewerking van het aangeboden materiaal of probleem, dan ligt het voor de hand om de student ook die door hem uitgevoerde bewerking in te laten leveren (al is het alleen maar het kladpapier waarop de nodige berekeningen staan aangegeven, terwijl op het antwoordformulier alleen de uitkomst, de gekozen alternatieven, vermeld worden). In bepaalde gevallen zal de kwaliteit van de 'materiaalbewerking' zelf ter beoordeling zijn (naast het uiteindelijk resultaat), dan gaat het om wat uitvoeriger essays, werkstukken. In andere gevallen gaat het misschien om een selectie uit aangeboden informatie die op zich ook in meerkeuzevraagvorm gegoten kan worden: dan ontstaat weer een dubbele meerkeuzevraag waarin zowel een keuze uit aangeboden alternatieve categorieën, diagnoses, en dergelijke gedaan moet worden, als aangegeven moet worden op grond van welke informatie die keuze(n) werd(en) gemaakt.

Bijzondere zorgvuldigheid is ook met deze vraagsoort weer geboden: de overbodige of vuile informatie die je in het gegeven probleem stopt kan als 'afleider' werken, en dat lijkt alleen te verdedigen wanneer de student zich ook heeft geoefend om verleidelijke maar irrelevante informatie te negeren, zich daardoor niet op het verkeerde been te laten zetten. Je kunt daarbij denken aan gevallen van onjuiste diagnosestelling waartegen de arts zich heeft te wapenen. Het gaat natuurlijk niet aan om strikvragen te bedenken die verder in de betreffende discipline van geen enkel belang zijn.

Dit is de meer algemene vorm van de onder 3.1.1 behandelde vraagvorm. De student krijgt nu geen aanwijzingen meer tussen welke alternatieven hij moet beslissen. Ook zijn die alternatieven niet impliciet gegeven, althans niet wanneer het maar om een klein aantal zou gaan, want dan zijn we immers helemaal terug bij vraagvorm 3.1.1. Verdere toelichting is hier dan ook nauwelijks nodig. Uiteraard is de meerkeuzevraag hier niet meer te gebruiken. Deze vraagvorm is een stuk moeilijker dan 3.1.1: de student moet hier op eigen kompas de alternatieven zien te vinden waartussen de beslissing in feite te maken is.

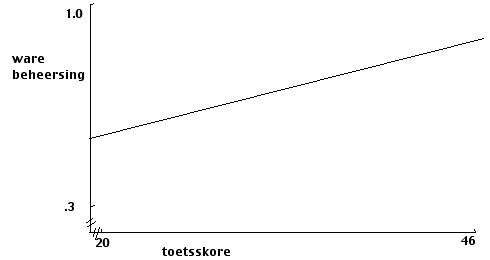

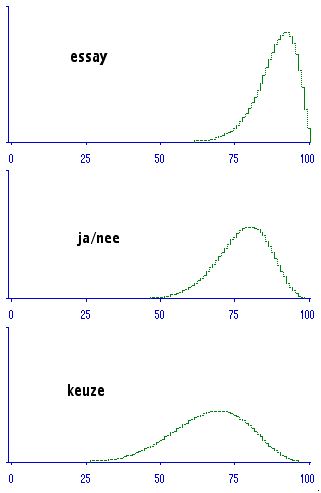

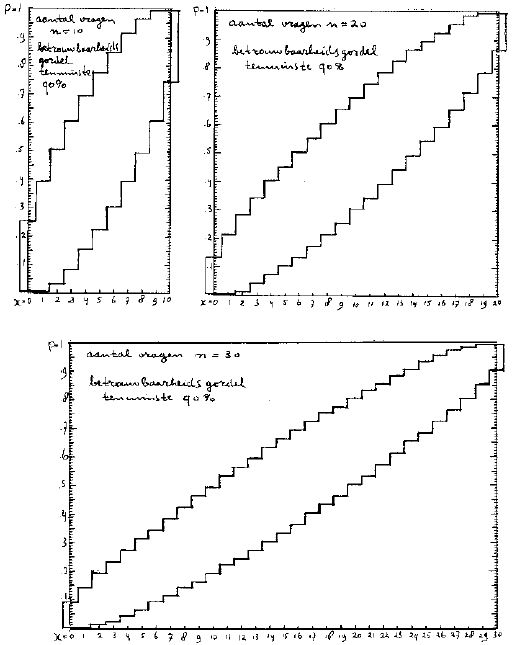

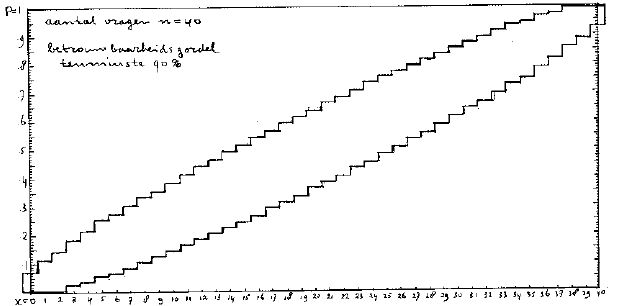

Om dit soort vragen redelijk te kunnen beantwoorden zal de student de betreffende begrippen (categorieën, diagnoses, classen, technieken etc) tenminste voldoende paraat moeten hebben om ze bij de gegeven situatie te kunnen passen, op het gegeven voorbeeld te kunnen matchen. Naar die 'paraatheid' van het begrippenapparaat moet in het voorafgaande onderwijs dan ook toe gewerkt zijn. De student moet deze begrippen niet alleen beschikbaar weten, weten te 'adresseren', hij moet ze ook weten te hanteren.